Intelligence Artificielle ou artifice d’intelligence ?

/Pas un jour, pas une heure sans qu’un media ne nous parle d’IA, ne nous dise combien nous risquons de perdre notre âme, nos emplois et tout le reste avec le déferlement prochain de l’Intelligence Artificielle, tout cela créant une certaine anxiété sur notre avenir proche.

Pour faire le tri entre réalités et fantasmes, l’agence Cymbioz* a organisé une rencontre avec des experts qualifiés pour débattre et pour parler de la cybersécurité de l’IA:

Damien Gbiorczyk – expert cyber chez Illumio

Olivier Daloy – RSSI Zscaler France

Vincent Lavergne – expert IA chez F5

et Eric Domage – Principal Analyst – Cybersecurity, PAC France

« L’IA pour quoi faire ?» a permis d’ouvrir un débat passionnant et passionné avec les journalistes présents…

Le constat

L’IA ne se limite plus à l’expérimentation, elle s’intègre au cœur des stratégies technologiques et métiers.

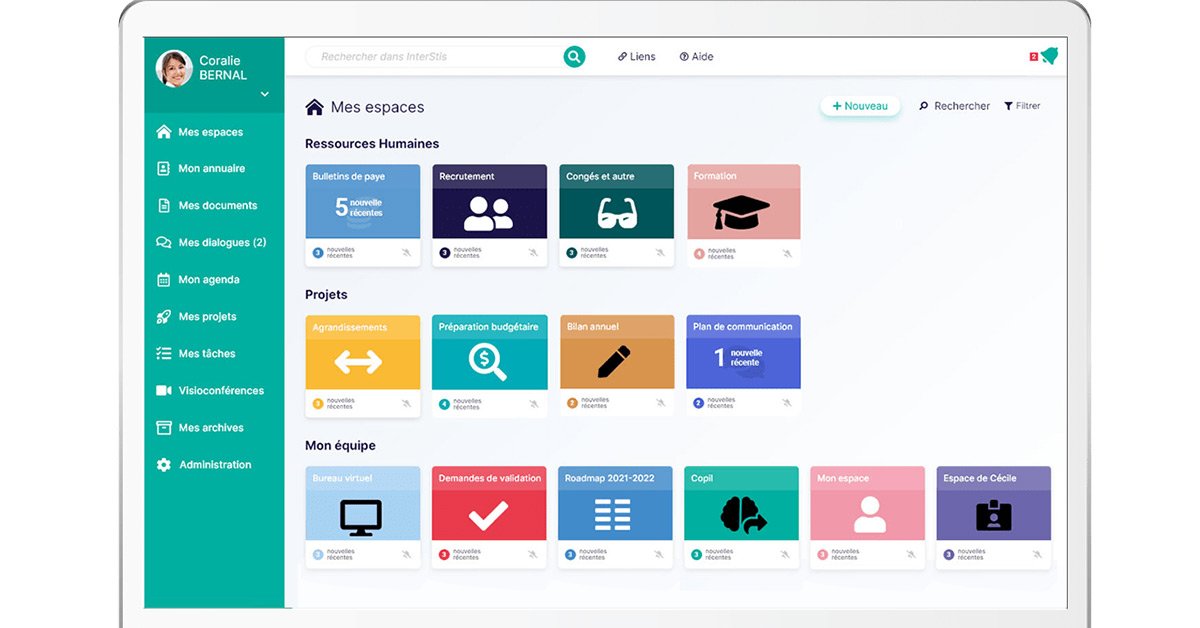

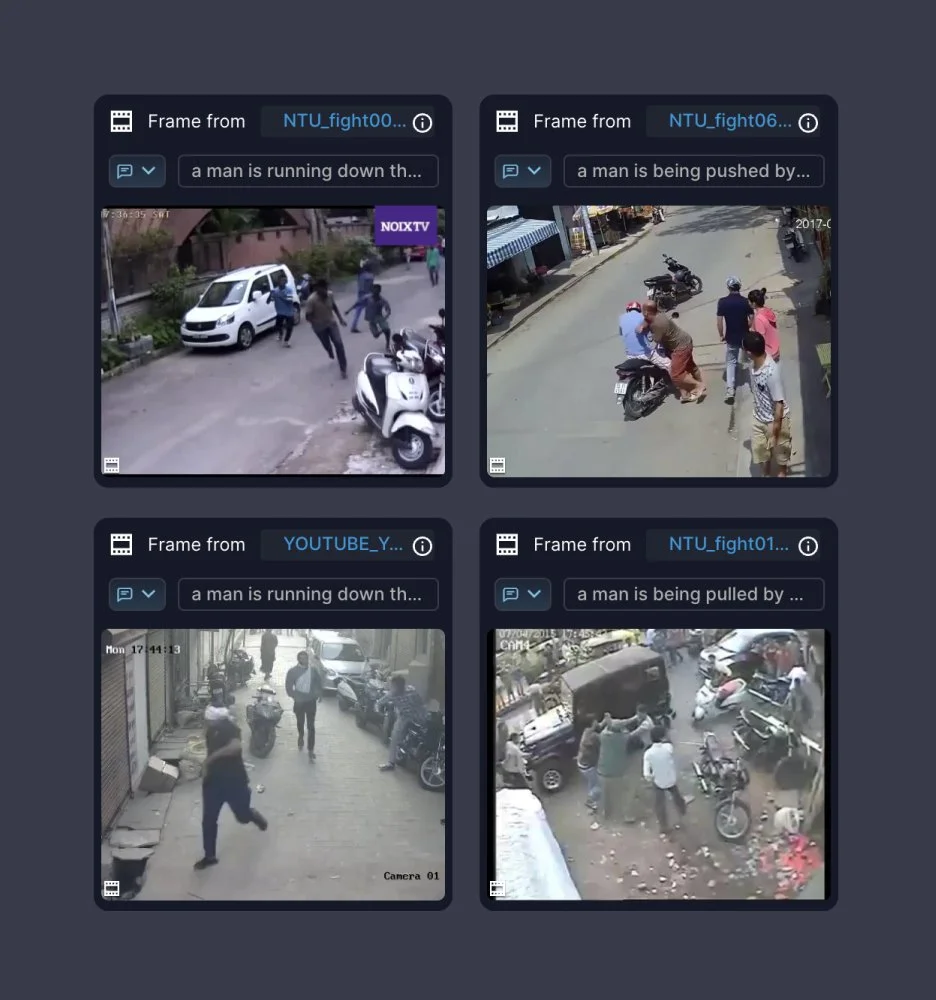

Agents autonomes intégrés aux applications, IA générative appliquée aux processus métiers, nouveaux modèles de gouvernance et de risque, SOC augmenté par l’IA, sécurisation des LLM** beaucoup de questions et un constat : les entreprises sont parfois dans une phase d’adoption massive (Finances, Santé, Commerce de détail), avec, en toile de fond, des questions clés sur la souveraineté des données, la réglementation et la maîtrise des coûts.

L’IA peut-elle rester un levier de compétitivité sans sacrifier la souveraineté des données?

Comment les organisations se préparent-elles à auditer et documenter l’usage de l’IA dans leurs processus métiers?

Que deviennent nos données quand elles sont utilisées pour entraîner des modèles d’IA?

Comment l’intégration massive de l’IA va-t-elle transformer les modèles économiques des entreprises d’ici 2026?

30 % de la croissance des API seront liés à l’IA d’ici 2026 : comment les RSSI peuvent-ils sécuriser cette nouvelle surface d’exposition?

Comment protéger les modèles d’IA eux-mêmes contre les attaques et les manipulations de données d’entraînement?

Comment éviter le “shadow AI”, ces usages non maîtrisés qui contournent les politiques IT?

Les RSSI et DSI ont-ils aujourd’hui les leviers pour sécuriser des systèmes dopés à l’IA?

Le risque

Le risque, c’est d’aller très vite, sans réfléchir et sans fondations solides.

Une étude récente de Zscaler*** fait état d’une augmentation de 93 % des usages de l’IA en entreprise. Une adoption fulgurante, souvent non encadrée, qui se traduit par un recours massif à des outils externes et par une exposition croissante des données : conséquence, des modèles dont les conditions d’entraînement, d’hébergement ou de réutilisation restent floues pour de nombreuses organisations.

En outre, d’après les RSSI, il y aurait 20% de « shadow IT » dans les entreprises, autant dire une part importante d’outils à l’IA non maitrisée…Avec pour conséquence des données internes, parfois sensibles ou stratégiques, injectées dans des outils utilisant des modèles étrangers (chinois ou américains).

La gouvernance

Face à cette réalité, il faut sortir d’une approche binaire. Il ne s’agit ni de bloquer l’IA, ni de l’adopter sans discernement, mais de poser des arbitrages clairs : quels usages sont autorisés, avec quels outils, pour quels types de données et sous quelle responsabilité ?

Produire avec l’IA suppose un changement de posture : passer d’une logique d’outil miracle à une logique de co-construction entre l’Humain et la machine. Cela implique des investissements durables dans la formation, mais aussi une remise à plat des processus métiers, des responsabilités et des modes de validation.

À défaut, l’IA risquerait de rester un gadget coûteux et passager, voire un facteur de risque opérationnel, juridique et de réputation pour l’entreprise ou l’organisation.

**LLM (Large Language Model) : type de programme d'intelligence artificielle capable de reconnaître et de générer du texte.